Wie ChatGPT das Wissensmanagement unterstützen kann

Künstliche Intelligenz bietet bereits viele Möglichkeiten, aus vorhandenem Wissen Lösungen für die künftige Arbeitswelt zu entwickeln. Eine Arbeitsgruppe hat sich zum Ziel gesetzt, bereits bestehende Möglichkeiten für die SIGUV nutzbar zu machen – mit Erfolg.

Die Veröffentlichung von ChatGPT im November 2022 bedeutete auch für die Welt der Künstlichen Intelligenz (KI) einen echten Quantensprung. Zum ersten Mal überhaupt gelang es, aus einer Vielzahl von vorhandenen Informationen ganz neue Inhalte generieren zu lassen („generative Künstliche Intelligenz“). Die technische Fähigkeit von Maschinen, Algorithmen und mathematischen Modellen der KI, neuen Content auf Basis von Benutzereingaben und Fragestellungen zu generieren, wurde innerhalb nur eines Jahres für Texte, Bilder und für bewegte Bilder (Animationen, Videos) weiterentwickelt. Große und leistungsfähige Cloudsysteme wie Amazon AWS und Microsoft Azure bringen diese Technologien zu jedem Unternehmen und zu jedem Privathaushalt.

Den enormen Chancen, die sich bei Nutzung dieser Technologien ergeben, stehen jedoch ebenso große Risiken gegenüber. Sensible Daten und Informationen können in Richtung der Technologieanbieter und ihrer sogenannten Large Language Models („LLM“) abfließen. Zudem können Urheberrechte verletzt werden, weil für das Generieren neuer Inhalte auf bereits vorhandenen Content zurückgegriffen wird. Zu klären sind dann Fragen wie: Was ist wirklich neu? An welcher Stelle wurde ein Originaltext verwendet, ohne das Zitat zu kennzeichnen?

Die novareto GmbH ist mit der externen Leitung der SIGUV-Web-Community beauftragt. Der Technikdienstleister educorvi GmbH & Co. KG gehört zur novareto Gruppe und hat sich mit einem kleinen Team von Studierenden der Friedrich-Alexander-Universität Erlangen-Nürnberg das Ziel gesetzt, die Chancen generativer KI für die SIGUV-Interessengemeinschaft zu eruieren. Ergebnisse der „Grundlagenforschung“ sollen mittel- und langfristig auch in die Entwicklungen der SIGUV-Web-Community einfließen. Zugleich will die Gruppe alle erforderlichen technischen und organisatorischen Maßnahmen ergreifen, um die Sicherheit einer solchen Lösung zu gewährleisten. Man nennt dieses Prinzip „Security by Design“.

Für die Nutzung generativer KI für die eigene Wissensbasis hat sich mittlerweile der Begriff Retrieval Augmented Generation (RAG) etabliert. Dabei handelt es sich um eine Technik zur Verarbeitung natürlicher Sprache (NLP), bei der abfragebasierte und generative Modelle der KI kombiniert werden. Das Ziel von RAG KI ist die Nutzung bereits vorhandenen Wissens, um möglichst genaue Ergebnisse zu erzielen.

Der von der Berufsgenossenschaft Handel und Warenlogistik (BGHW) angebotene Shared Service „Intranet-Wissensmanagement“ (INWI) bildet eine solche Wissensbasis. Bisher kann man sich das Wissen des BGHW INWI-RuL über

- die ausgefeilte thematisch orientierte Navigationsstruktur oder

- eine Volltextsuche erschließen.

Die Aufgabe bestand nun darin, zu ermitteln, ob aus dieser Wissensbasis gut formulierte Antworten auf natürliche Fragestellungen oder sogar auf eine Folge von aufbauenden Fragen und Antworten, also für den Kontext eines Gespräches zwischen Mensch und Maschine, gewonnen werden könnten.

Die Arbeitsgruppe hat diese Aufgabe in vier Quadranten zerlegt (siehe Anhang, Folie 2):

- Im ersten Quadranten strukturieren wir den Content des INWI-Wissensmanagements in entsprechende Artikeltypen (Container) mit einer Vielzahl von Merkmalen (Attributen) im sogenannten Portal-Catalog. Hier kann bereits festgelegt werden, welche Inhalte oder Inhaltstypen aus Sicherheitsgründen nicht einem externen Sprachmodell zugeführt werden können. Zudem kann man festlegen, in welchem Publikationsstatus Content an das externe Modell übermittelt werden darf.

Autoren und Redakteure können den Content mit Suchbegriffen anreichern und Administratoren können festlegen, welche Bedeutung einzelnen Merkmalen der Inhalte beigemessen werden soll. Alternativ wird dieser Content im strukturierten JSON-Format exportiert oder über Schnittstellen externen Suchmaschinen zur Indexierung angeboten. - Im zweiten Quadranten widmen wir uns der Frage, wie die Daten für anfrageorientierte KI-Modelle aufgearbeitet werden können. Dabei kommen praktisch alle verfügbaren Technologien für offene Suchmaschinen, die einen Eigenbetrieb ermöglichen (z.B. ElaticSearch, Solr oder Typesense) in Frage. Ein Nebeneffekt des Projektes war, dass wir für das INWI sehr erfolgreich verschiedene Alternativen für die Bereitstellung einer verbesserten Volltextsuche testen konnten. Außerdem ist es gelungen, in PDFs eingebettete Bilder mit Text in aus technischer Sicht vertretbarer Zeit für die Volltextsuche zu indexieren. Alternativ zur Suchmaschine werden die Daten und Informationen des INWI in einer sogenannten Vektordatenbank gespeichert. Schon bei diesem Prozess der Aufbereitung der Daten kommen KI-Modelle zum Einsatz – denn die Texte müssen in viele kleine Bestandteile zerlegt werden.

Die Vektoren muss man sich als mehrdimensionale, interne Verlinkungen zwischen den Textbausteinen vorstellen. Dem Large-Language-Modell (LLM) können auf diese Weise verschiedene Möglichkeiten angeboten werden, um per Abfrage (Query) den zu Benutzereingabe bzw. zur Benutzerfragestellung passenden Content herauszusuchen: eine Suchmaschine und alternativ dazu eine Vektordatenbank. Wichtig anzumerken ist, dass in diesem Schritt aus Sicherheitsgründen (Security by Design) nur KI-Modelle verwendet werden, die im Eigenbetrieb genutzt werden können. - Der dritte Quadrant stellt die technische Verbindung zwischen dem eigenen Content und dem sogenannten Large-Language-Modell her. Hier schießen nahezu jeden Tag neue technische Lösungen aus dem Boden. Aktuell nutzen wir für unser Projekt den Open-Source Framework LangChain und haben darin Prozesse für das sogenannte Prompt-Engineering, die Abfrage der Datenbasis und vor allem auch für die Bildung von Quellenangaben implementiert, die wir für essenziell halten, um die Integrität und Richtigkeit der gegebenen Antwort überprüfbar zu machen.

- Der vierte Quadrant repräsentiert das LLM, das für die Analyse und Aufbereitung der Fragestellungen und schließlich auch für das Generieren von Antworten verwendet wird.

Im ersten Projekt hat sich die Arbeitsgruppe auf den Platzhirsch Open AI konzentriert. Sie ist jetzt in der Lage, alle bekannten Modelle von OpenAI in die von ihr entwickelten Lösungen zu integrieren. An dieser Stelle besteht aus Sicht der Datensicherheit und des Datenschutzes das größte Risiko. Das gilt insbesondere dann, wenn das Modell für das Generieren der Antworten nicht im eigenen Rechenzentrum betrieben werden kann – wie bei OpenAI und ChatGPT.

Die Gruppe hat aber ermittelt, dass es möglich ist, die ChatGPT-Modelle auch über die Microsoft Azure Cloud zu nutzen – denn im Gegensatz zu Open AI bekennt sich Microsoft zur europäischen Datenschutzgrundverordnung (DSGVO). Inzwischen arbeitet die Gruppe auch intensiv an Lösungen, die den Betrieb eines geeigneten LLM im eigenen Rechenzentrum erlauben.

Fazit: educorvi verfügt für die SIGUV-Interessengemeinschaft heute über eine funktionsfähige RAG-Lösung auf Basis von OpenAI und ChatGPT, die das Unternehmen noch in diesem Jahre für alle öffentlich verfügbaren und zugänglichen Informationen, also z.B. für Webseiten und Webmagazine, veröffentlichen kann.

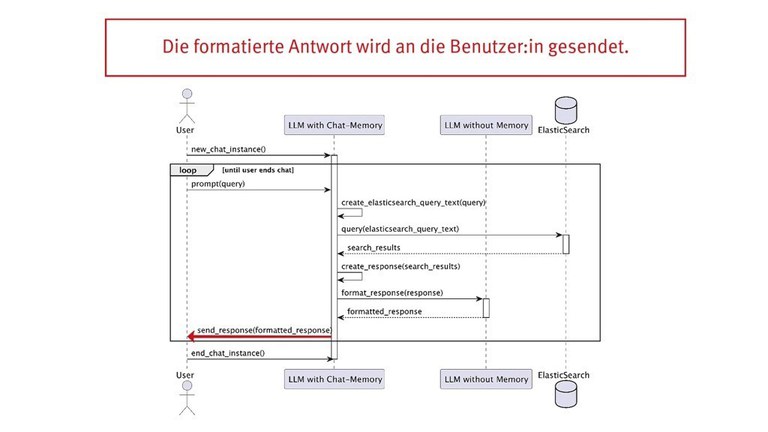

Der Ablauf eines Gespräches mit dem Chatbot ChatGPT stellt sich damit kurz zusammengefasst so dar (siehe Grafik unten):

- Die Anwenderinnen und Anwender konfrontieren den Chatbot mit einer Fragestellung.

- Die Fragestellung wird vom Large-Language-Modell (LLM) für die Abfrage der Suchmaschine oder der Vektordatenbank aufbereitet.

- Die eigene Datenbasis (Suchmaschine oder Vektordatenbank) wird abgefragt.

- Die besten Treffer werden als Kontext zur Fragestellung dem LLM übergeben. Die Treffer werden außerdem für die Bildung der Quellenangabe aufbereitet.

- Das LLM generiert die Antwort für die Anwenderinnen und Anwender und wird ihnen angezeigt.

- Webcode: 23643560